GTMF2023東京会場,ゲーム開発に特化したソリューション/サービス28社の展示レポート

2023年7月4日,秋葉原UDXで「Game Tools & Middleware Forum 2023東京」(以下,GTMF)が開催された。東京と大阪で開催されているイベントの東京大会である。大阪でのイベントは,6月30日に行われている。

ここでは,GTMF展示会場での各社の展示の模様を紹介してみたい(※記載はブース番号順。なお,写真はなるべく人のいないタイミングで撮影しているので,人が写っていなくても寂れていたわけではない)。

東陽テクニカではアセット管理ツールのHelix Coreが展示されていた。Gitなどと似たバージョン管理ツールだと思えばよいだろう。Gitがテキスト中心であるのに対して,Helix Coreはバイナリデータに強く,ゲーム向きのソリューションである。

最近の動きを聞いてみると,Web上でアセットの確認ができるツールが開発されて簡易に扱えるようになったこと,ファイル一覧などの取得が軽量化されたことなどが挙げられるという。コンテンツ管理はよいのだが,リモートでの作業が多くなると,細い回線での操作性を上げるためにいろいろと改善が行われていたようだ。

ユニティでは,新しくなったURPやHDRPのデモとUnity Gaming Servicesに関する展示を行っていた。

Unity標準のレンダーパイプラインは2種類とも進化が進んでいる。URPではスマホなどのデバイスでもかなりリアル寄りの絵が出せるようになってきている(写真の左側の画面)。

URPについては,最初は軽いレンダーパイプライン(LWRP:Light Weight Rendar Pipeline)という位置づけだったのが,汎用のレンダーパイプライン(Universal Rendar Pipeline)となり,どんどん重くなっているのが個人的に少し気がかりではある。

もともと,以前のUnityのパイプラインは互換性を取るためにレガシーなものから最新のものまで全部詰め込まれていて,ハイエンドな絵がほしい人にも軽い絵がほしい人にも無駄な部分が多くなりすぎたということで,レンダーパイプラインを自由に定義できるようにしようと,カスタマイズ可能にされたのがこれらの始まりだ。

そのゲームに必要な要素だけでレンダーパイプラインを作れるようにするということだったはずだが,自前でレンダーパイプラインを作ったという話は聞いたことがない。それだけUnity標準のモノがよくできていたというのもあるのだろう。HDRPもURPもよくなった。URPで十分軽いということなのだろうが,より軽いパイプラインについては忘れ去られてしまっているのかもしれない。

話は変わってクラウドサーバーを使ったオンラインゲーム支援のUnity Gaming Servicesである。かなり以前から,Unityはオンラインゲーム関連のツールやサービスを行う会社を買収していた。クラウドの事業者からアナリティクスの会社,チャットサービス,モバイル広告など,Unityの関連サービスのように扱われていたこともあったが,それらをまとめて磨き上げたソリューションがUnity Gaming Servicesとなる。

特徴としては,汎用サービスであることで,Unreal Engineで作ったゲームで使ってもまったく問題がない(すでに事例もあるようだ)。また,機能単位で提供されるので,他社のサービスと組み合わせることも柔軟にできる。マルチプレイゲームの作成支援からサービス運営の補助,そしてマネタイズの改善までトータルにサポートするものとなっている。

なお,Unity AIについては発表されたばかりでまだ詳細ははっきりしていない。CEDECや東京ゲームショウあたりに期待しよう。

Unreal Engine用のサウンドプラグインが10年以上前に作られたものということもあって,新しく作り直されたのだという。前バージョンでのさまざまな要望を取り入れて操作性の改善が施されているそうだ。これまでは音のアセットが1つ単位でファイルになっていたが,複数のファイルをまとめた形式にしつつ,検索などはそのままできるようになっている。

また,CRI-VODとして展示されていたデモでは,同社の映像ミドルウェアSofdecのデータをサーバー上に置いて,ストリーミング再生ができるようなものとして実装されていた。すでにNintendo Switch用のABEMAアプリで使用されている。Video on demandとはちょっと違う感じもあり,タイトルは変更される可能性があるとのことだ(TMマークをついてるが……)。

そのほかのツールでもさまざまな改善が行われており,デモムービーとして流されていたのだが,あまりに項目が多かったので,ここではOPTPiXに絞って紹介する。

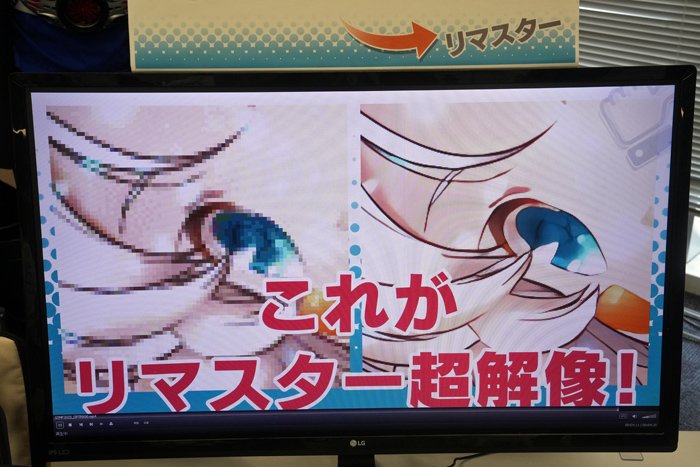

OPTPiXの本業は減色なのだが,高品質な,画像の拡大機能が搭載されていた。写真を見ても分かるように,単純拡大するとギザギザな線もそれっぽい曲線に変換される。古いゲームのHDリマスター版を出すといった場合に,古い画像をどうやってHD版にするのかが問題になるが,これを使えば,手直しが必要な場合があったとしても,新たに描き起こすよりは格段に楽になるだろう。

UNREAL FESTが終わったばかりということで,新規発表のネタはないというエピックだが,会場ではGDCで発表された最新のデモElectric Dreams Environmentなどが稼働していた。

なお会場のデモマシンはGeForce RTX 3080搭載とのこと。GDCではRTX 4090搭載のマシンでデモされていたのだが,ハイエンド寄りの環境が必要にはなるものの,最新GPUが必須というわけでもないようだ。

Electric Dreams Environmentは,Megascansの高精度アセット,Naniteでマスク付きテクスチャが使えるようになったこと,プロシージャルツールがサポートされたことなどがあって実現した高密度な森林を扱うオープンワールドデモだ。

プロシージャルな広いオープンワールドと聞くと,Unreal Engine 4のKiteデモを思い出す人もいるかもしれない。比べてみるとレンダリング自体も進化しており,樹木の密度が段違いだ。

なお,UE5.2の機能については,別途セッションレポートで紹介する予定だ。

ヤマハブースでは,オブジェクトベースの3Dサウンド技術「SoundxR」のデモが行われていた。

オブジェクトベースの立体音響などは最近ではあちこちがやっているわけだが,それらのほとんどは一度仮想的な7.1chスピーカーを構成して,そこからヘッドフォンに落とし込んでいるのだという。それに対してSoundxRではダイレクトに音源座標からの音を扱っている。それに加えて,HRTFの精度が高く,非常に高品質な3Dサウンドを実現しているという。カプコンに採用されている技術でもある。

また,HRTFなどが精密であれば再生環境も厳しくなるのかと聞いてみると,とくに使用するヘッドフォンなどを選ばないとのこと。100均で売っているようなものならともかく,普通のゲーマーが買うような製品であればまったく問題はないそうだ。

現状でSoundxRはUnity版とWwise版が用意されており,いずれかでゲームに組み込むことができる。

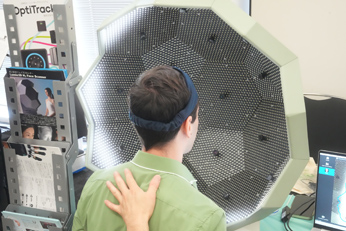

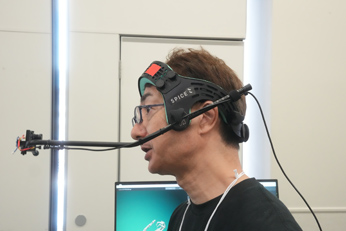

スパイスは,フェイシャルキャプチャ関連の展示を行っていた。まず,フェイシャルキャプチャの元になる顔データの作成用機材などがデモされていた。

6角形を張り合わせた半ドーム形状の内側には,無数のLEDと16個の小型カメラが設置されている。ここに頭を入れて一度に顔全体を撮影するのだ。撮影された画像から非常に精緻な点群を取得し,それをもとにメッシュを生成する。ノーマルデータなどは取得しないのだが,毛穴レベルの非常に精緻なメッシュまで作成可能なので,必要であれば別のツールで作成すればよいだろうというスタンスだ。

顔のモーションを記録するカメラは,顔の前までアームを伸ばして小さなカメラで撮影するタイプだ。バーチャルなアイドルが踊り回っても大丈夫なものをというオファーに応えるために作ったそうで,Avatarの新作で使われたフェイシャルカメラ機材を作った会社に依頼して製作したものだとのこと。激しく首を振ってもずれない。テザーレスで扱えるので踊り回っても問題ない。

会場のデモでは5GHz帯での接続だったが,現在6GHz帯での技適申請を出しているところだそうだ(ハード自体は対応している)。10人弱が一度に使うと5GHz帯では情報落ちが出ることがあるとのことで,6GHz対応に期待がかけられていた。

マーケティングアソシエーションは,主にユーザーサポート窓口業務を担当する会社だ。ゲーム業界だとほぼメール対応だそうだが,場合によってはチャット対応,さらにコールセンターも用意されている。

この手の業界では珍しく,すべて正社員が対応しているのが特徴だとのことだ。バイトや日本語が怪しい外注スタッフなどではない。いろんな意味で激務なので人の入れ替わりが激しい業種ではあるものの,苦情対応などに不向きは人は早めに配置転換することで離職率を抑えているのだそうだ。長く務めた社員がいれば,それだけ担当分野の知識も溜まり,より的確なサポートが行えるようになる,とサービスレベルの高さが強調されていた。

また,関連して,ゲームのデバッグなどの業務も行っているという。

今回はChatGPTなどのAI全推しだったMicrosoft。Bing上で動くものの,モノ自体はOpenAIが提供しているChatGPTなどと変わらない。機密情報などを学習しないといったセキュリティ面が強調されていた。なお,これはOpenAIでもAPI利用時には同じことなのだが,新興企業よりもMicrosoftが保証するという点に価値があるとの認識のようだ。企業ユースでは説得力のあるポイントだろう。なお,利用料金はOpenAIと比べるとちょっとお高めとのこと。そのぶん,レスポンスなどの性能が保証されている。

なお,GPTで問題になる情報に対する正確性の担保などについては,最終的には使う人間が判断するしかないとのことではあった。デリケートな話題については,LLM以外にコンテンツを監視するAIが入っており,そちらで制限がかかるといったシステムになっているという。

画像生成AIのDALL-Eのサービスも提供されているが,業界的に懸念される著作権問題については,Microsoftは担保しないとの立場のようだ。あくまでも利用者自身の判断と責任で使えということなのだろう。

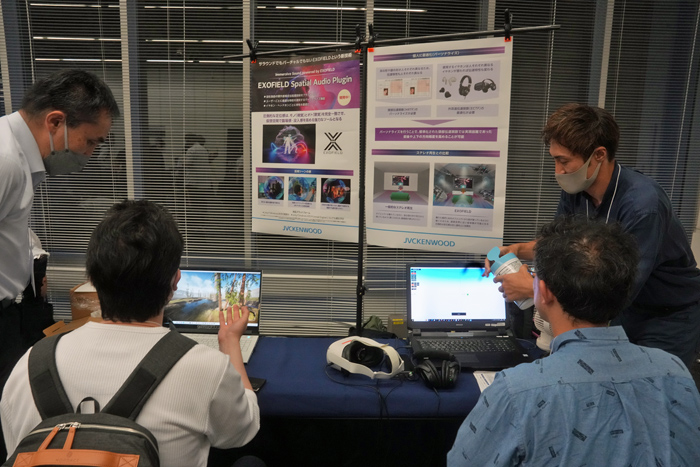

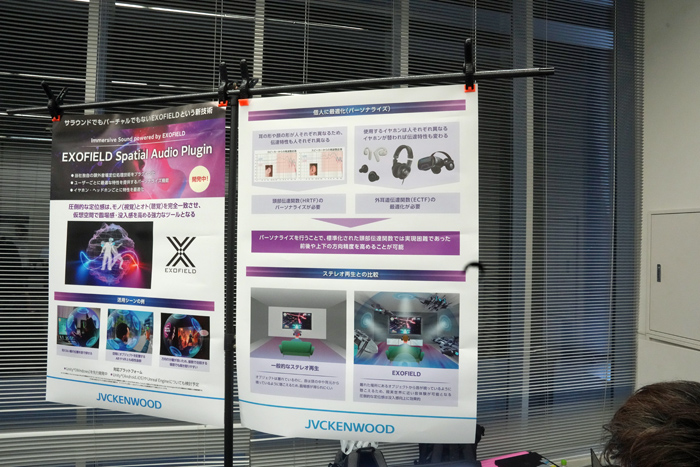

JVCケンウッドでは「EXOFIELD Spatial Audio Plugin」という3Dサウンド系プラグインのデモを行っていた。

この手の話でよく出てくるHRTFは,スピーカーから耳に届くまでの音の経路に関する関数だ。部屋自体,そして人の上半身や頭,主に外耳の形状に依存してくる。カメラで耳の形状を撮影して,それをもとに自動生成するようなアプローチを行っているところがあることも有名な話だろう。

ただ,耳の形状が問題になるのは主にスピーカーを使っている場合である。耳の穴の真上からダイレクトに音を浴びせてくるヘッドフォンでは意味は薄くなり,カナル型のイヤフォンに関してはまったく関係がなくなる。そんなときに使われるのが外耳道伝達関数(ECTF)だそうで,部屋の残響や耳の形などに関係なく,スピーカーと鼓膜(と外耳道,つまり耳の穴)の関係で完結するものとなる。

EXOFIELDでは,HRTFとECTFの2つの関数を使って,より精密に最適化が可能になるという。オーディオ機器メーカーであるJVCケンウッドでは,HRTFに関するデータの蓄積が非常に多く,品質には自信を持っているようだった。

なお,今回のデモでは8種類のHRTF+ECTFの組み合わせから一番適したものを選ぶという方式だった。今後は変更されるかもしれないとのことだったが,自動で決められるよりも,自分の耳で聞いて一番よく聞こえるものを選ぶほうが納得しやすいといった利用によるもののようだ。

GEO展であちこちに話を聞くと,この手のプラットフォームはGoogle MapかMapboxかという感じだったのだが,ロケーションベースのゲームで重要となる,入ってはいけない道などの情報の更新をGoogleが止めるとかで,今後はMapboxに期待がかかっているようだ。

多くのレイヤーを設定でき,多彩な使い方ができるMapboxだが,無料枠があるので気軽に機能を試すこともできる。これはAPIコール5万回(だったと思う)までは無料で使えるというものだ。5万回というのがどれくらいか判断しにくいのだが,学生がちょっと作ったツールみたいなものでは全然届かないとのことだった。Mapbox Studioを使えばコードを書くことなくさまざまな機能にアクセスできるので,ちょっとしたものを試してみるのもいいだろう。

電車位置のリアルタイム追跡マップや地震速報データをビジュアライズするもの,温暖化時の潮位変化での水没をシミュレーションするものなど,ブースではユーザーが作ったいくつかのデモも紹介されていた。

Mpbox採用タイトルとしては,クローズドβテストが行われていたコーエーテクモの「信長の野望 出陣」の正式サービスも控えているほか,いくつかのタイトルが準備中だという。

エルザでは,GeForce RTX 4090を積んだPC,RTX 4060を積んだノートPCの両方で,重いことで知られるUE5の「Matrix Awakens」デモを走らせてどれくらい動くのかという体験デモが行われていた。さすがにRTX 4090のほうは普通に動く。ノートPCでも多少重いながらちゃんと動作していた。

同社ではこういったゲーム制作向けのワークステーションやノートPCなどを扱っている。

SBペイメントサービスは,ゲームでの決済をサポートする会社だ。クレジットカードやキャリア決済のほか多くの決済手段に対応している。最近ではiPhoneでも外部決済が行われるようになっており,30%というプラットフォーム税を回避する手段が出てきた。これらの会社はより低い料率での決済を可能にするものとなる。

特徴は,やはりその料率にあるという。一般的な決済代行業者では外部のクレジットカード会社と提携して決済を行っているのに対して,同社ではグループ企業によるPayPayやキャリア決済の強みもさることながら,自身がVISA,Masterの代理店となっているため他社よりも有利な料率が提供できるのだという。

また,ゲームで特有な不正行動を検知して,事前に弾くことができる。アカウント売買などの場合,不正に入手したクレジットカード情報で課金アイテムを買い揃えて売りに出すことが多く,短期間に多種のカードが使用される傾向にある。そういった怪しい決済は止めたり,グレーなものは別途クレジットカード会社本体に問い合わせたりといった対応を行っているとのこと。

オンラインゲームのNHNが培ったチート対策ソリューションをまとめたものが「NHN AppGuard」だ。同社のツムツムシリーズなどでは多くのチートツールが出回っており,チート対策は重要な課題となっている。その対策ツールを一般向けに提供しているわけだ。

対策ツールはSDKとして組み込まれ,既知のチートへのパターンマッチングのほかにヒューリスティック検出やビヘイビア検出なども組み合わせている。それでもイタチごっことなるチートツールへの対応には,チートの世界的な動向を踏まえて迅速に対応する体制を整えているという。

料金はデバイス単位で,毎月,1万デバイスまでは無料で使えるため,小規模なゲームでは試しやすい設定だ。ただ,台数と料金がリニアではないので少し注意が必要かもしれない。月に20万台ちょうどだったら26万4000円(1.32円/台:※これが最高値)だが,20万1台だったら5万5000円(0.275円/台)になる。100万1台だと総額で1万1000円(0.011円/台)ということで,かなり分かりづらい。

最近ではゲーム以外の分野にも注力しているLive2D。GTMFではツール本体というよりも,同社の制作部隊であるCreative Studioをメインとした出展が行われていた。セッションでは,Unityでの使い方の講演も実施されていた。

春に発表されたCubism 5のα版ではAI機能を使ったツールの開発もアナウンスされていたので尋ねてみたのだが,正面顔を入れるといろんな角度からの顔を生成してくれるようなものであるらしい。個人的には1枚絵からのレイヤー分けをAIで自動化できないものかと具申してきたのだが,画像系のAIにポジティブに取り組んでいるのも,同社の過去の画像データの蓄積が大量にあるためだろう。今後の成果に期待したい。

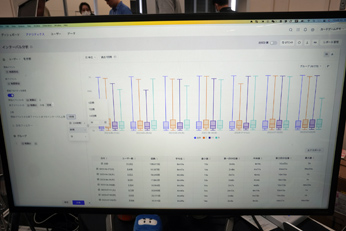

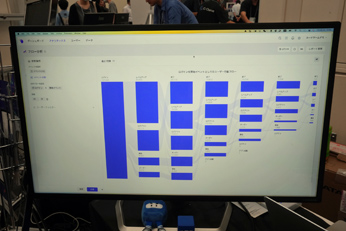

シンキングデータはゲーム内のユーザーの行動などを可視化する分析ツールを提供している会社である。

こういったアナリティクスツールは多くのプラットフォームで用意されている種類のものではあるが,同社の特徴としてはプログラマに頼むことなく必要なデータを取り出せるオペレーションの容易さを挙げていた。

一般的なKPIを並べたダッシュボードのほかに,ユーザーの行動を見るようなデモを見せてもらった。例えば戦闘時間の長さを示すのが左下の写真だ。おそらくターン制のゲームなのだろうが,最短で10数秒,平均で8分程度,最長では1時間(集計単位を1時間にしているため)といったデータが戦闘ごと,日ごとに表示されている。

下の右側は,ログインしてログアウトするまでに,どういった行動の遷移をしているかを示したものである。時間の経過順に並べられている。

どういったことがやりたいのかをヒアリングしてデータを構築するので,初期設定は必要になるようだが,設定が終われば誰でもこういったデータを簡単に取り扱えることができるようになるという。

Speech Graphicsは,音声データで駆動するキャラクターアニメーションを提供する会社である。音声からのリップシンクだけであれば多くのツールでサポートされている機能なのだが,同社のソフトでは,口だけでなく,顔全体の感情表現までを再現することができる。これは音声データのみで行われるもので,リアルタイム処理である。音声データに含まれる感情的な成分を検出しているようで,特定の言語に依存することなく,どんな言語でも,架空の言語にも対応できるとのことだ。言語が特定されている場合であれば,さらに正確なリップシンクを行うことも可能だ。

面白いのは,表示されている話者のアバターだけでなく,それを聞いているNPCリスナーの感情表現も行えるという点だ。

今後,ChatGPTなどによる自然会話を取り入れて,NPCと会話できるようなゲームが登場してくる(春のAI Expoでの取材によるとそろそろ採用タイトルが出てくるはず)。そういった場合に,話者や会話相手以外のNPCのリアクションがより自然に行えるようになるわけだ。もはや,ただ突っ立っているだけのNPCでは味気ないだろう。このようなソフトの注目度は高まりそうだ。

ゲームでの,主に2D絵の校正・管理ツールとして生まれたBrushupだが,最近はゲーム以外の,あらゆるコンテンツ制作の現場で使われるようになってきているようだ。導入先に市役所などもあって首をかしげていたのだが,市報の制作過程で導入されているのだそうだ。

機能としては大きな変更は行われていないようだが,クラウドでのコンテンツ管理,ガントチャートでの進捗管理,チャットでのコミュニケーション,直接的な赤入れ対応など,コンテンツ制作の過程を幅広くサポートしてくれる。

10アカウント,10プロジェクト,ストレージ100MBの範囲であれば無料のエントリープランが利用できるので,この手のツールに興味のある人は試してみるのもよいだろう。

日本ではあまり得意でないところが多いサーバーサイドのプログラム開発。Game Server ServiceのGS2は,SaaS形式で提供される汎用のゲームサーバー機能群と基本の管理機能(運営ツール,サポートツール,解析ツール)によって構成されている。必要な機能を組み合わせるだけで,サーバー側のコードを書く必要はない。

最近では採用事例も広がっており,大手からインディーまで幅広く使われているようだ。

多種多様なゲーム開発関連ツール,ミドルウェアの代理店ともなっているTooでは,さまざまな製品を紹介していた。もはやモデリング時の標準ツールと言ってもよいZBrushをはじめとしたMaxon製品,NeuronからXSENS,Viconに至るモーションキャプチャソリューション,服飾作成ツールのMaevelous Designerなどまで幅広い製品の代理店となっている。

目新しいところでは,エフェクトツールのRED GIANTとFlashback製品というものがあった。RED GIANTはAfterEffectsやPremiere Proなどの映像ツールで使用されるMaxonのプラグインで,霧や炎といったパーティクル系を得意としているようだ(トランシジョンなど機能自体は多彩)。

FlashbackはVFX関連を得意とする会社で,グロー処理やパーティクル処理,VFXのプラグインのほか,単体ツールとして群集アニメーション用のAnimaや地形制作ツールのWorld Creatorなどが取り揃えられていた。

Tooではゲーム関連以外でも多くのツールを扱っており(Zoomとかも),最近ではオンラインホワイトボードのMiroの扱いなども行っている。

また,同社は3DCGクリエイターのためのゲーム開発ドラフト会議というものも行っている。これはアマチュアの3DCGクリエイターのポートフォリオをゲーム会社各社が審査してマッチングを行うというものだ。今年の締め切りは7月31日までなので興味のある人は,早めに公式サイトを見てみよう。

慣性型のモーションキャプチャスーツXSENSを国内で展開するゼロシーセブンでは,実演デモを行っていた。

XSENSは,慣性測定センサー(IMU:Inertial Measurement Unit)を使ったモーションキャプチャシステムでは最も高精度なものであり,特別なスタジオを必要とせず,屋外などでも取り扱えるなどといった利点がある。

体の動きは17か所にセンサーを取り付けたスーツで行い,専用ソフトウェアで処理される。ゼロシーセブンではXSENS以外のソリューションも組み合わせることで,身体以外のキャプチャにもトータルで対応しており,フェイシャルについてはiPhoneでのキャプチャ,指の動きはデータグローブでのキャプチャで対応している。いずれもテザーレスで運用できるものだ。最近ではスーツと組み合わせるグローブをMANUSのMetaglovesに更新して,指の動きがより精細に取れるようになったという。

XSENSのIMUは扱いやすく動きの精度も高い方式だが,慣性式なので長く動いていると誤差の蓄積は避けられない。ある程度は自動で補正するようだが,複数人での長時間のキャプチャなどでは,Vive Trackerを利用することを推奨しているようだ(屋外では衛星信号)。基準になる位置情報だけであれば,カメラを使ったソリューションよりは安く実現できる。

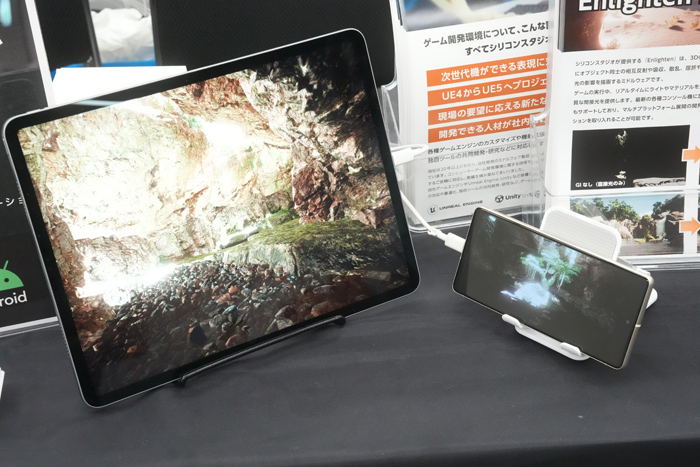

シリコンスタジオでは,GIツールのEnlightenをメインに展示を行っていた。3Dグラフィックスのリアリティが向上してきて,リアルなGIの実現は重要な課題となっている。陰影をベイクすることで,ある程度それらしい絵を作ることは可能だが,動きがあるシーンでは不自然になることも多い。また,ベイク自体に時間がかかるので,シーンの光源設定などで作業が非効率になることも避けられない。ハイエンドであればUnreal EngineのLumenのようなソリューションも利用できるのであろうが,より非力なデバイスであるタブレットやスマートフォンでは利用しにくいのが実情だ。

Enlightenは,そういった非力なデバイスでも自然なGIを実現できるソリューションである。ベイク作業なしで,リアルタイムに光源を変更できる。

今回の展示で聞いてみたところ,機能的に大きな動きはないようではあるが,ライトプローブの改善などで地道に品質は向上しているようだ。会場では,実際にタブレットやスマホ上で高原の変化に対してGI効果が適用されるシーンがデモされていた。

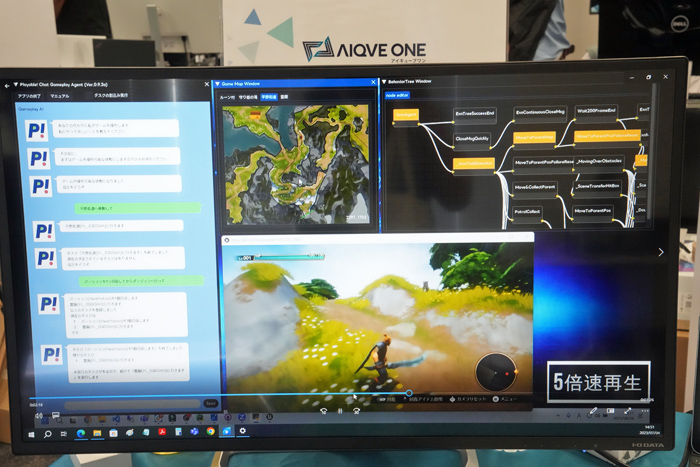

AIQVE ONEはAIを利用したデバッグソリューションを提供する会社である。いろいろ研究しているところはあるが,実際にAIでデバッグを行っているのは同社だけだという。気になって「モリカトロンさんはやってますよね?」と聞いてみると,モリカトロン系(monoAI系か)の会社であった。システムの開発自体はモリカトロンが行っているものだそうだ。

どのようなAIなのかというと,LLM(大規模言語モデル)を使って自然言語で指示したとおりにゲームを自動で進めてくれるというのだ。「ポーションを1個取ってダンジョンに向かって」という指示を出すと,指示を解析したうえでビヘイビアツリーを駆使して目的を達成するように行動させるのだという。

デバッグだと,AIで算出するような最適ルートではなく,むしろ無駄なルートをたどるほうが効率は上がることが考えられる。そうした場合でもAIで対応できるそうだ。LLMが指示の意味を理解してくれるので,「できるだけ寄り道しながら行って」といった指定も可能なのだ。さらに使い込むことでAI自体の学習が進み,より使いやすいツールに成長していくことも期待できるという。

ブースの右側のマシンでは,壁などへのヒットチェックを9本同時に行っていた。壁抜けなどのデバッグ作業は人間が行うには辛い単調作業であり,できればAIに任せたい分野の筆頭であろう。展示の都合で9本同時に回しているだけで,実際にはもっと多くのゲームを同時デバッグすることも可能だ。もちろんゲーム側が対応すれば,時間加速をしてデバッグ時間を短縮することもできる。こういったことは人間がデバッグしている環境では実現しにくいものであろう。

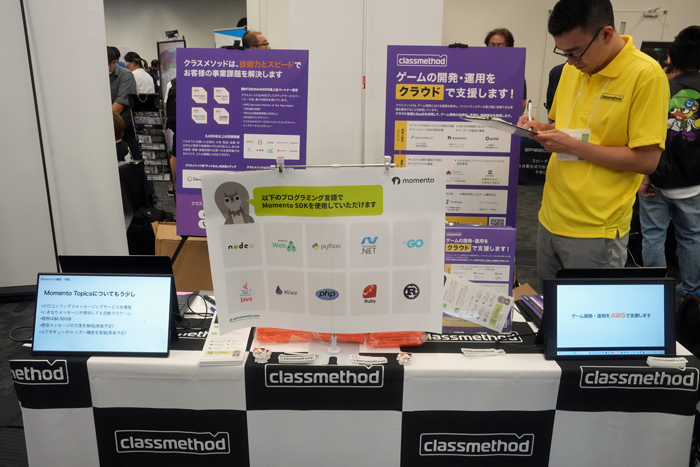

クラスメソッドは,自社でやっていたゲームをクラウドで展開したいといった企業をさまざまな形でサポートする会社だ。国内で12社しかないAWSの最上位パートナーということでAWSを得意としているようだが,GCPなどにも対応は可能とのこと。

クラウドへの移行に関しては豊富な経験を持っているので,コンサル的なところから始まって,ゲーム運営だけでなく開発の効率化などを含めたトータルな支援を行ってくれるという。

新世代の3Dハプティクス技術を展開するMIRAISENSは,PS5コントローラを使ったデモを展示していた。MIRAISENSは,特殊な周波数帯の振動を用いることで,人間の触感に錯覚を引き起こして単なる振動以上の効果を引き出すという技術である。

同社の技術は最新世代のゲーム機でなら実装可能ということだったのだが,実際のゲーム機のコントローラを使ったデモは初めて体験したと思う。感想としては,単純に効果音をもとにした振動に比べると蝕感は多彩ではあるものの,同社のアドバンテージだと思われる力感についてはあまり感じられなかったのが少し残念だった。横Gというか,コントローラに力がかかっている感じが薄かったのだ。最大設定にしてあるとのことだったのだが,DualSenseだとパワー不足だったのだろうか。

なんにしても表現力や没入感が向上することは間違いなく,今後登場するであろうタイトルでの使いこなしに期待したいところだ。

Diarkisはオンラインゲーム用のミドルウェアを提供する会社である。マッチメイカーやコミュニティ機能といったオンラインゲームに付随する機能のほかに,1対1の対戦であればP2P,数百人規模のバトルロイヤルゲーム向けにRoom機能,MMO用にField機能が用意されているという。

目玉はFieldのようなのだが,1ワールドに大量のプレイヤーを収容できることがウリだという。パンフレットを見ると同時接続数無制限が謳われている。どういうことかというと,クラウドベースのシステムなので,負荷によって自動的にスケールイン/アウトすることで処理を捌くということらしい。バーチャルコンサートのようなイベントでは10万人を収容した実績を持つという。MMORPGの同時接続記録だとだいたい200万人になるわけだが,そういったものもワールドを分けずに収容可能になるのだろう。

ゲームの規模に合わせたソリューションが用意されていることやトラフィックの増減に柔軟に対応できることなど,クラウド時代のオンラインゲーム基盤として注目すべき会社かもしれない。

スパークは,エフェクトツール「Spark Gear」を展開する会社である。ノードベースでエフェクトの開発ができ,一通りの機能を備えている。

昨今はゲームエンジンが提供するエフェクトツールが充実してきているのではあるが,UnityとUnreal Engineなど複数のゲームエンジンをまたぐ開発をしていると,開発側の学習コストが非常に高くつくようになってしまっているという。Cascade,Niagara,Shuriken,VFX Graphなどシステムが更新されると使い勝手も変わってくる。そこでどちらでも使えるエフェクトツールに絞って学習したほうが効率がよいというのだ。実際にUnityで作ったゲームをUnreal Engineに持ってくるといった事案もあったそうだが,そういった場合でもSparkを使っていればエフェクト部分は無変更で移行できたとのこと。

今後の動きとしてはUnityやUnreal Engineのマテリアルレンダラーを使った描画に対応していくとのことだ。これにより,エフェクトの素材をそれぞれのゲームエンジンのマテリアルと一元化できるようになる。

分散処理でさまざまなもののビルド処理を劇的に高速化するIncredibuild。新しい機能などはとくにないとのことで,ちょっと紹介に困ってしまうのだが,開発現場での定番ツールであり,代替製品もないのでしかたないのであろう。

VisualStudioのような純粋な開発ツール以外に,ゲームエンジンやシェーダのコンパイル,ライトマップのベイクなど,時間がかかる処理をネットワーク内のPCに分散して高速な処理が可能になる。クラウドサーバでの利用も可能だ。

プロジェクトがだんだん大きくなってきて,ビルド時間も馬鹿にならなくなってきたというところは導入を検討するのがよいだろう。

国産ゲームエンジンとして知られるOROCHIは,シリコンスタジオからAHIRUに移管して開発が続けられている。新たなOROCHI5では,主にUIの使い勝手を上げる改善と全体的なコードの見直しによる改良が行われているという。

国内での開発運営が行われているので,国内メーカーに対する手厚いサポートが特徴だ。これには,各社のニーズに合わせた専用のブランチによるエンジン提供をはじめ,技術者の派遣なども含まれる。多くのミドルウェアメーカーと提携しており,それらの組み込み費用がかからないなどといった特徴も備えている。

ここでは,GTMF展示会場での各社の展示の模様を紹介してみたい(※記載はブース番号順。なお,写真はなるべく人のいないタイミングで撮影しているので,人が写っていなくても寂れていたわけではない)。

東陽テクニカ

東陽テクニカではアセット管理ツールのHelix Coreが展示されていた。Gitなどと似たバージョン管理ツールだと思えばよいだろう。Gitがテキスト中心であるのに対して,Helix Coreはバイナリデータに強く,ゲーム向きのソリューションである。

最近の動きを聞いてみると,Web上でアセットの確認ができるツールが開発されて簡易に扱えるようになったこと,ファイル一覧などの取得が軽量化されたことなどが挙げられるという。コンテンツ管理はよいのだが,リモートでの作業が多くなると,細い回線での操作性を上げるためにいろいろと改善が行われていたようだ。

|

ユニティ・テクノロジーズ・ジャパン

ユニティでは,新しくなったURPやHDRPのデモとUnity Gaming Servicesに関する展示を行っていた。

Unity標準のレンダーパイプラインは2種類とも進化が進んでいる。URPではスマホなどのデバイスでもかなりリアル寄りの絵が出せるようになってきている(写真の左側の画面)。

URPについては,最初は軽いレンダーパイプライン(LWRP:Light Weight Rendar Pipeline)という位置づけだったのが,汎用のレンダーパイプライン(Universal Rendar Pipeline)となり,どんどん重くなっているのが個人的に少し気がかりではある。

もともと,以前のUnityのパイプラインは互換性を取るためにレガシーなものから最新のものまで全部詰め込まれていて,ハイエンドな絵がほしい人にも軽い絵がほしい人にも無駄な部分が多くなりすぎたということで,レンダーパイプラインを自由に定義できるようにしようと,カスタマイズ可能にされたのがこれらの始まりだ。

|

そのゲームに必要な要素だけでレンダーパイプラインを作れるようにするということだったはずだが,自前でレンダーパイプラインを作ったという話は聞いたことがない。それだけUnity標準のモノがよくできていたというのもあるのだろう。HDRPもURPもよくなった。URPで十分軽いということなのだろうが,より軽いパイプラインについては忘れ去られてしまっているのかもしれない。

話は変わってクラウドサーバーを使ったオンラインゲーム支援のUnity Gaming Servicesである。かなり以前から,Unityはオンラインゲーム関連のツールやサービスを行う会社を買収していた。クラウドの事業者からアナリティクスの会社,チャットサービス,モバイル広告など,Unityの関連サービスのように扱われていたこともあったが,それらをまとめて磨き上げたソリューションがUnity Gaming Servicesとなる。

特徴としては,汎用サービスであることで,Unreal Engineで作ったゲームで使ってもまったく問題がない(すでに事例もあるようだ)。また,機能単位で提供されるので,他社のサービスと組み合わせることも柔軟にできる。マルチプレイゲームの作成支援からサービス運営の補助,そしてマネタイズの改善までトータルにサポートするものとなっている。

なお,Unity AIについては発表されたばかりでまだ詳細ははっきりしていない。CEDECや東京ゲームショウあたりに期待しよう。

CRI・ミドルウェア

|

Unreal Engine用のサウンドプラグインが10年以上前に作られたものということもあって,新しく作り直されたのだという。前バージョンでのさまざまな要望を取り入れて操作性の改善が施されているそうだ。これまでは音のアセットが1つ単位でファイルになっていたが,複数のファイルをまとめた形式にしつつ,検索などはそのままできるようになっている。

|

また,CRI-VODとして展示されていたデモでは,同社の映像ミドルウェアSofdecのデータをサーバー上に置いて,ストリーミング再生ができるようなものとして実装されていた。すでにNintendo Switch用のABEMAアプリで使用されている。Video on demandとはちょっと違う感じもあり,タイトルは変更される可能性があるとのことだ(TMマークをついてるが……)。

|

そのほかのツールでもさまざまな改善が行われており,デモムービーとして流されていたのだが,あまりに項目が多かったので,ここではOPTPiXに絞って紹介する。

OPTPiXの本業は減色なのだが,高品質な,画像の拡大機能が搭載されていた。写真を見ても分かるように,単純拡大するとギザギザな線もそれっぽい曲線に変換される。古いゲームのHDリマスター版を出すといった場合に,古い画像をどうやってHD版にするのかが問題になるが,これを使えば,手直しが必要な場合があったとしても,新たに描き起こすよりは格段に楽になるだろう。

エピック ゲームズ ジャパン

UNREAL FESTが終わったばかりということで,新規発表のネタはないというエピックだが,会場ではGDCで発表された最新のデモElectric Dreams Environmentなどが稼働していた。

なお会場のデモマシンはGeForce RTX 3080搭載とのこと。GDCではRTX 4090搭載のマシンでデモされていたのだが,ハイエンド寄りの環境が必要にはなるものの,最新GPUが必須というわけでもないようだ。

|

Electric Dreams Environmentは,Megascansの高精度アセット,Naniteでマスク付きテクスチャが使えるようになったこと,プロシージャルツールがサポートされたことなどがあって実現した高密度な森林を扱うオープンワールドデモだ。

プロシージャルな広いオープンワールドと聞くと,Unreal Engine 4のKiteデモを思い出す人もいるかもしれない。比べてみるとレンダリング自体も進化しており,樹木の密度が段違いだ。

なお,UE5.2の機能については,別途セッションレポートで紹介する予定だ。

ヤマハ

ヤマハブースでは,オブジェクトベースの3Dサウンド技術「SoundxR」のデモが行われていた。

オブジェクトベースの立体音響などは最近ではあちこちがやっているわけだが,それらのほとんどは一度仮想的な7.1chスピーカーを構成して,そこからヘッドフォンに落とし込んでいるのだという。それに対してSoundxRではダイレクトに音源座標からの音を扱っている。それに加えて,HRTFの精度が高く,非常に高品質な3Dサウンドを実現しているという。カプコンに採用されている技術でもある。

また,HRTFなどが精密であれば再生環境も厳しくなるのかと聞いてみると,とくに使用するヘッドフォンなどを選ばないとのこと。100均で売っているようなものならともかく,普通のゲーマーが買うような製品であればまったく問題はないそうだ。

現状でSoundxRはUnity版とWwise版が用意されており,いずれかでゲームに組み込むことができる。

|

スパイス

|

スパイスは,フェイシャルキャプチャ関連の展示を行っていた。まず,フェイシャルキャプチャの元になる顔データの作成用機材などがデモされていた。

6角形を張り合わせた半ドーム形状の内側には,無数のLEDと16個の小型カメラが設置されている。ここに頭を入れて一度に顔全体を撮影するのだ。撮影された画像から非常に精緻な点群を取得し,それをもとにメッシュを生成する。ノーマルデータなどは取得しないのだが,毛穴レベルの非常に精緻なメッシュまで作成可能なので,必要であれば別のツールで作成すればよいだろうというスタンスだ。

|

|

顔のモーションを記録するカメラは,顔の前までアームを伸ばして小さなカメラで撮影するタイプだ。バーチャルなアイドルが踊り回っても大丈夫なものをというオファーに応えるために作ったそうで,Avatarの新作で使われたフェイシャルカメラ機材を作った会社に依頼して製作したものだとのこと。激しく首を振ってもずれない。テザーレスで扱えるので踊り回っても問題ない。

|

|

会場のデモでは5GHz帯での接続だったが,現在6GHz帯での技適申請を出しているところだそうだ(ハード自体は対応している)。10人弱が一度に使うと5GHz帯では情報落ちが出ることがあるとのことで,6GHz対応に期待がかけられていた。

マーケティングアソシエーション

マーケティングアソシエーションは,主にユーザーサポート窓口業務を担当する会社だ。ゲーム業界だとほぼメール対応だそうだが,場合によってはチャット対応,さらにコールセンターも用意されている。

この手の業界では珍しく,すべて正社員が対応しているのが特徴だとのことだ。バイトや日本語が怪しい外注スタッフなどではない。いろんな意味で激務なので人の入れ替わりが激しい業種ではあるものの,苦情対応などに不向きは人は早めに配置転換することで離職率を抑えているのだそうだ。長く務めた社員がいれば,それだけ担当分野の知識も溜まり,より的確なサポートが行えるようになる,とサービスレベルの高さが強調されていた。

また,関連して,ゲームのデバッグなどの業務も行っているという。

日本マイクロソフト

|

今回はChatGPTなどのAI全推しだったMicrosoft。Bing上で動くものの,モノ自体はOpenAIが提供しているChatGPTなどと変わらない。機密情報などを学習しないといったセキュリティ面が強調されていた。なお,これはOpenAIでもAPI利用時には同じことなのだが,新興企業よりもMicrosoftが保証するという点に価値があるとの認識のようだ。企業ユースでは説得力のあるポイントだろう。なお,利用料金はOpenAIと比べるとちょっとお高めとのこと。そのぶん,レスポンスなどの性能が保証されている。

なお,GPTで問題になる情報に対する正確性の担保などについては,最終的には使う人間が判断するしかないとのことではあった。デリケートな話題については,LLM以外にコンテンツを監視するAIが入っており,そちらで制限がかかるといったシステムになっているという。

画像生成AIのDALL-Eのサービスも提供されているが,業界的に懸念される著作権問題については,Microsoftは担保しないとの立場のようだ。あくまでも利用者自身の判断と責任で使えということなのだろう。

JVCケンウッド

|

JVCケンウッドでは「EXOFIELD Spatial Audio Plugin」という3Dサウンド系プラグインのデモを行っていた。

この手の話でよく出てくるHRTFは,スピーカーから耳に届くまでの音の経路に関する関数だ。部屋自体,そして人の上半身や頭,主に外耳の形状に依存してくる。カメラで耳の形状を撮影して,それをもとに自動生成するようなアプローチを行っているところがあることも有名な話だろう。

ただ,耳の形状が問題になるのは主にスピーカーを使っている場合である。耳の穴の真上からダイレクトに音を浴びせてくるヘッドフォンでは意味は薄くなり,カナル型のイヤフォンに関してはまったく関係がなくなる。そんなときに使われるのが外耳道伝達関数(ECTF)だそうで,部屋の残響や耳の形などに関係なく,スピーカーと鼓膜(と外耳道,つまり耳の穴)の関係で完結するものとなる。

|

EXOFIELDでは,HRTFとECTFの2つの関数を使って,より精密に最適化が可能になるという。オーディオ機器メーカーであるJVCケンウッドでは,HRTFに関するデータの蓄積が非常に多く,品質には自信を持っているようだった。

なお,今回のデモでは8種類のHRTF+ECTFの組み合わせから一番適したものを選ぶという方式だった。今後は変更されるかもしれないとのことだったが,自動で決められるよりも,自分の耳で聞いて一番よく聞こえるものを選ぶほうが納得しやすいといった利用によるもののようだ。

マップボックス・ジャパン

以前GEO展でも紹介したマップボックスもGTMFに出展していた。GEO展であちこちに話を聞くと,この手のプラットフォームはGoogle MapかMapboxかという感じだったのだが,ロケーションベースのゲームで重要となる,入ってはいけない道などの情報の更新をGoogleが止めるとかで,今後はMapboxに期待がかかっているようだ。

多くのレイヤーを設定でき,多彩な使い方ができるMapboxだが,無料枠があるので気軽に機能を試すこともできる。これはAPIコール5万回(だったと思う)までは無料で使えるというものだ。5万回というのがどれくらいか判断しにくいのだが,学生がちょっと作ったツールみたいなものでは全然届かないとのことだった。Mapbox Studioを使えばコードを書くことなくさまざまな機能にアクセスできるので,ちょっとしたものを試してみるのもいいだろう。

電車位置のリアルタイム追跡マップや地震速報データをビジュアライズするもの,温暖化時の潮位変化での水没をシミュレーションするものなど,ブースではユーザーが作ったいくつかのデモも紹介されていた。

Mpbox採用タイトルとしては,クローズドβテストが行われていたコーエーテクモの「信長の野望 出陣」の正式サービスも控えているほか,いくつかのタイトルが準備中だという。

エルザ・ジャパン

エルザでは,GeForce RTX 4090を積んだPC,RTX 4060を積んだノートPCの両方で,重いことで知られるUE5の「Matrix Awakens」デモを走らせてどれくらい動くのかという体験デモが行われていた。さすがにRTX 4090のほうは普通に動く。ノートPCでも多少重いながらちゃんと動作していた。

同社ではこういったゲーム制作向けのワークステーションやノートPCなどを扱っている。

|

SBペイメントサービス

|

SBペイメントサービスは,ゲームでの決済をサポートする会社だ。クレジットカードやキャリア決済のほか多くの決済手段に対応している。最近ではiPhoneでも外部決済が行われるようになっており,30%というプラットフォーム税を回避する手段が出てきた。これらの会社はより低い料率での決済を可能にするものとなる。

特徴は,やはりその料率にあるという。一般的な決済代行業者では外部のクレジットカード会社と提携して決済を行っているのに対して,同社ではグループ企業によるPayPayやキャリア決済の強みもさることながら,自身がVISA,Masterの代理店となっているため他社よりも有利な料率が提供できるのだという。

また,ゲームで特有な不正行動を検知して,事前に弾くことができる。アカウント売買などの場合,不正に入手したクレジットカード情報で課金アイテムを買い揃えて売りに出すことが多く,短期間に多種のカードが使用される傾向にある。そういった怪しい決済は止めたり,グレーなものは別途クレジットカード会社本体に問い合わせたりといった対応を行っているとのこと。

NHN テコラス

|

オンラインゲームのNHNが培ったチート対策ソリューションをまとめたものが「NHN AppGuard」だ。同社のツムツムシリーズなどでは多くのチートツールが出回っており,チート対策は重要な課題となっている。その対策ツールを一般向けに提供しているわけだ。

対策ツールはSDKとして組み込まれ,既知のチートへのパターンマッチングのほかにヒューリスティック検出やビヘイビア検出なども組み合わせている。それでもイタチごっことなるチートツールへの対応には,チートの世界的な動向を踏まえて迅速に対応する体制を整えているという。

料金はデバイス単位で,毎月,1万デバイスまでは無料で使えるため,小規模なゲームでは試しやすい設定だ。ただ,台数と料金がリニアではないので少し注意が必要かもしれない。月に20万台ちょうどだったら26万4000円(1.32円/台:※これが最高値)だが,20万1台だったら5万5000円(0.275円/台)になる。100万1台だと総額で1万1000円(0.011円/台)ということで,かなり分かりづらい。

Live2D

|

最近ではゲーム以外の分野にも注力しているLive2D。GTMFではツール本体というよりも,同社の制作部隊であるCreative Studioをメインとした出展が行われていた。セッションでは,Unityでの使い方の講演も実施されていた。

春に発表されたCubism 5のα版ではAI機能を使ったツールの開発もアナウンスされていたので尋ねてみたのだが,正面顔を入れるといろんな角度からの顔を生成してくれるようなものであるらしい。個人的には1枚絵からのレイヤー分けをAIで自動化できないものかと具申してきたのだが,画像系のAIにポジティブに取り組んでいるのも,同社の過去の画像データの蓄積が大量にあるためだろう。今後の成果に期待したい。

シンキングデータ

シンキングデータはゲーム内のユーザーの行動などを可視化する分析ツールを提供している会社である。

こういったアナリティクスツールは多くのプラットフォームで用意されている種類のものではあるが,同社の特徴としてはプログラマに頼むことなく必要なデータを取り出せるオペレーションの容易さを挙げていた。

一般的なKPIを並べたダッシュボードのほかに,ユーザーの行動を見るようなデモを見せてもらった。例えば戦闘時間の長さを示すのが左下の写真だ。おそらくターン制のゲームなのだろうが,最短で10数秒,平均で8分程度,最長では1時間(集計単位を1時間にしているため)といったデータが戦闘ごと,日ごとに表示されている。

下の右側は,ログインしてログアウトするまでに,どういった行動の遷移をしているかを示したものである。時間の経過順に並べられている。

|

|

どういったことがやりたいのかをヒアリングしてデータを構築するので,初期設定は必要になるようだが,設定が終われば誰でもこういったデータを簡単に取り扱えることができるようになるという。

Speech Graphics

|

Speech Graphicsは,音声データで駆動するキャラクターアニメーションを提供する会社である。音声からのリップシンクだけであれば多くのツールでサポートされている機能なのだが,同社のソフトでは,口だけでなく,顔全体の感情表現までを再現することができる。これは音声データのみで行われるもので,リアルタイム処理である。音声データに含まれる感情的な成分を検出しているようで,特定の言語に依存することなく,どんな言語でも,架空の言語にも対応できるとのことだ。言語が特定されている場合であれば,さらに正確なリップシンクを行うことも可能だ。

面白いのは,表示されている話者のアバターだけでなく,それを聞いているNPCリスナーの感情表現も行えるという点だ。

今後,ChatGPTなどによる自然会話を取り入れて,NPCと会話できるようなゲームが登場してくる(春のAI Expoでの取材によるとそろそろ採用タイトルが出てくるはず)。そういった場合に,話者や会話相手以外のNPCのリアクションがより自然に行えるようになるわけだ。もはや,ただ突っ立っているだけのNPCでは味気ないだろう。このようなソフトの注目度は高まりそうだ。

Brushup

ゲームでの,主に2D絵の校正・管理ツールとして生まれたBrushupだが,最近はゲーム以外の,あらゆるコンテンツ制作の現場で使われるようになってきているようだ。導入先に市役所などもあって首をかしげていたのだが,市報の制作過程で導入されているのだそうだ。

機能としては大きな変更は行われていないようだが,クラウドでのコンテンツ管理,ガントチャートでの進捗管理,チャットでのコミュニケーション,直接的な赤入れ対応など,コンテンツ制作の過程を幅広くサポートしてくれる。

10アカウント,10プロジェクト,ストレージ100MBの範囲であれば無料のエントリープランが利用できるので,この手のツールに興味のある人は試してみるのもよいだろう。

|

Game Server Service

|

日本ではあまり得意でないところが多いサーバーサイドのプログラム開発。Game Server ServiceのGS2は,SaaS形式で提供される汎用のゲームサーバー機能群と基本の管理機能(運営ツール,サポートツール,解析ツール)によって構成されている。必要な機能を組み合わせるだけで,サーバー側のコードを書く必要はない。

最近では採用事例も広がっており,大手からインディーまで幅広く使われているようだ。

Too

|

多種多様なゲーム開発関連ツール,ミドルウェアの代理店ともなっているTooでは,さまざまな製品を紹介していた。もはやモデリング時の標準ツールと言ってもよいZBrushをはじめとしたMaxon製品,NeuronからXSENS,Viconに至るモーションキャプチャソリューション,服飾作成ツールのMaevelous Designerなどまで幅広い製品の代理店となっている。

目新しいところでは,エフェクトツールのRED GIANTとFlashback製品というものがあった。RED GIANTはAfterEffectsやPremiere Proなどの映像ツールで使用されるMaxonのプラグインで,霧や炎といったパーティクル系を得意としているようだ(トランシジョンなど機能自体は多彩)。

FlashbackはVFX関連を得意とする会社で,グロー処理やパーティクル処理,VFXのプラグインのほか,単体ツールとして群集アニメーション用のAnimaや地形制作ツールのWorld Creatorなどが取り揃えられていた。

Tooではゲーム関連以外でも多くのツールを扱っており(Zoomとかも),最近ではオンラインホワイトボードのMiroの扱いなども行っている。

また,同社は3DCGクリエイターのためのゲーム開発ドラフト会議というものも行っている。これはアマチュアの3DCGクリエイターのポートフォリオをゲーム会社各社が審査してマッチングを行うというものだ。今年の締め切りは7月31日までなので興味のある人は,早めに公式サイトを見てみよう。

ゼロシーセブン

慣性型のモーションキャプチャスーツXSENSを国内で展開するゼロシーセブンでは,実演デモを行っていた。

XSENSは,慣性測定センサー(IMU:Inertial Measurement Unit)を使ったモーションキャプチャシステムでは最も高精度なものであり,特別なスタジオを必要とせず,屋外などでも取り扱えるなどといった利点がある。

体の動きは17か所にセンサーを取り付けたスーツで行い,専用ソフトウェアで処理される。ゼロシーセブンではXSENS以外のソリューションも組み合わせることで,身体以外のキャプチャにもトータルで対応しており,フェイシャルについてはiPhoneでのキャプチャ,指の動きはデータグローブでのキャプチャで対応している。いずれもテザーレスで運用できるものだ。最近ではスーツと組み合わせるグローブをMANUSのMetaglovesに更新して,指の動きがより精細に取れるようになったという。

|

XSENSのIMUは扱いやすく動きの精度も高い方式だが,慣性式なので長く動いていると誤差の蓄積は避けられない。ある程度は自動で補正するようだが,複数人での長時間のキャプチャなどでは,Vive Trackerを利用することを推奨しているようだ(屋外では衛星信号)。基準になる位置情報だけであれば,カメラを使ったソリューションよりは安く実現できる。

シリコンスタジオ

|

シリコンスタジオでは,GIツールのEnlightenをメインに展示を行っていた。3Dグラフィックスのリアリティが向上してきて,リアルなGIの実現は重要な課題となっている。陰影をベイクすることで,ある程度それらしい絵を作ることは可能だが,動きがあるシーンでは不自然になることも多い。また,ベイク自体に時間がかかるので,シーンの光源設定などで作業が非効率になることも避けられない。ハイエンドであればUnreal EngineのLumenのようなソリューションも利用できるのであろうが,より非力なデバイスであるタブレットやスマートフォンでは利用しにくいのが実情だ。

Enlightenは,そういった非力なデバイスでも自然なGIを実現できるソリューションである。ベイク作業なしで,リアルタイムに光源を変更できる。

今回の展示で聞いてみたところ,機能的に大きな動きはないようではあるが,ライトプローブの改善などで地道に品質は向上しているようだ。会場では,実際にタブレットやスマホ上で高原の変化に対してGI効果が適用されるシーンがデモされていた。

|

AIQVE ONE

|

AIQVE ONEはAIを利用したデバッグソリューションを提供する会社である。いろいろ研究しているところはあるが,実際にAIでデバッグを行っているのは同社だけだという。気になって「モリカトロンさんはやってますよね?」と聞いてみると,モリカトロン系(monoAI系か)の会社であった。システムの開発自体はモリカトロンが行っているものだそうだ。

どのようなAIなのかというと,LLM(大規模言語モデル)を使って自然言語で指示したとおりにゲームを自動で進めてくれるというのだ。「ポーションを1個取ってダンジョンに向かって」という指示を出すと,指示を解析したうえでビヘイビアツリーを駆使して目的を達成するように行動させるのだという。

|

デバッグだと,AIで算出するような最適ルートではなく,むしろ無駄なルートをたどるほうが効率は上がることが考えられる。そうした場合でもAIで対応できるそうだ。LLMが指示の意味を理解してくれるので,「できるだけ寄り道しながら行って」といった指定も可能なのだ。さらに使い込むことでAI自体の学習が進み,より使いやすいツールに成長していくことも期待できるという。

ブースの右側のマシンでは,壁などへのヒットチェックを9本同時に行っていた。壁抜けなどのデバッグ作業は人間が行うには辛い単調作業であり,できればAIに任せたい分野の筆頭であろう。展示の都合で9本同時に回しているだけで,実際にはもっと多くのゲームを同時デバッグすることも可能だ。もちろんゲーム側が対応すれば,時間加速をしてデバッグ時間を短縮することもできる。こういったことは人間がデバッグしている環境では実現しにくいものであろう。

クラスメソッド

|

クラスメソッドは,自社でやっていたゲームをクラウドで展開したいといった企業をさまざまな形でサポートする会社だ。国内で12社しかないAWSの最上位パートナーということでAWSを得意としているようだが,GCPなどにも対応は可能とのこと。

クラウドへの移行に関しては豊富な経験を持っているので,コンサル的なところから始まって,ゲーム運営だけでなく開発の効率化などを含めたトータルな支援を行ってくれるという。

ミライセンス

|

新世代の3Dハプティクス技術を展開するMIRAISENSは,PS5コントローラを使ったデモを展示していた。MIRAISENSは,特殊な周波数帯の振動を用いることで,人間の触感に錯覚を引き起こして単なる振動以上の効果を引き出すという技術である。

同社の技術は最新世代のゲーム機でなら実装可能ということだったのだが,実際のゲーム機のコントローラを使ったデモは初めて体験したと思う。感想としては,単純に効果音をもとにした振動に比べると蝕感は多彩ではあるものの,同社のアドバンテージだと思われる力感についてはあまり感じられなかったのが少し残念だった。横Gというか,コントローラに力がかかっている感じが薄かったのだ。最大設定にしてあるとのことだったのだが,DualSenseだとパワー不足だったのだろうか。

なんにしても表現力や没入感が向上することは間違いなく,今後登場するであろうタイトルでの使いこなしに期待したいところだ。

Diarkis

|

Diarkisはオンラインゲーム用のミドルウェアを提供する会社である。マッチメイカーやコミュニティ機能といったオンラインゲームに付随する機能のほかに,1対1の対戦であればP2P,数百人規模のバトルロイヤルゲーム向けにRoom機能,MMO用にField機能が用意されているという。

目玉はFieldのようなのだが,1ワールドに大量のプレイヤーを収容できることがウリだという。パンフレットを見ると同時接続数無制限が謳われている。どういうことかというと,クラウドベースのシステムなので,負荷によって自動的にスケールイン/アウトすることで処理を捌くということらしい。バーチャルコンサートのようなイベントでは10万人を収容した実績を持つという。MMORPGの同時接続記録だとだいたい200万人になるわけだが,そういったものもワールドを分けずに収容可能になるのだろう。

ゲームの規模に合わせたソリューションが用意されていることやトラフィックの増減に柔軟に対応できることなど,クラウド時代のオンラインゲーム基盤として注目すべき会社かもしれない。

スパーク

|

スパークは,エフェクトツール「Spark Gear」を展開する会社である。ノードベースでエフェクトの開発ができ,一通りの機能を備えている。

昨今はゲームエンジンが提供するエフェクトツールが充実してきているのではあるが,UnityとUnreal Engineなど複数のゲームエンジンをまたぐ開発をしていると,開発側の学習コストが非常に高くつくようになってしまっているという。Cascade,Niagara,Shuriken,VFX Graphなどシステムが更新されると使い勝手も変わってくる。そこでどちらでも使えるエフェクトツールに絞って学習したほうが効率がよいというのだ。実際にUnityで作ったゲームをUnreal Engineに持ってくるといった事案もあったそうだが,そういった場合でもSparkを使っていればエフェクト部分は無変更で移行できたとのこと。

今後の動きとしてはUnityやUnreal Engineのマテリアルレンダラーを使った描画に対応していくとのことだ。これにより,エフェクトの素材をそれぞれのゲームエンジンのマテリアルと一元化できるようになる。

Incredibuild Japan

分散処理でさまざまなもののビルド処理を劇的に高速化するIncredibuild。新しい機能などはとくにないとのことで,ちょっと紹介に困ってしまうのだが,開発現場での定番ツールであり,代替製品もないのでしかたないのであろう。

VisualStudioのような純粋な開発ツール以外に,ゲームエンジンやシェーダのコンパイル,ライトマップのベイクなど,時間がかかる処理をネットワーク内のPCに分散して高速な処理が可能になる。クラウドサーバでの利用も可能だ。

プロジェクトがだんだん大きくなってきて,ビルド時間も馬鹿にならなくなってきたというところは導入を検討するのがよいだろう。

OROCHI

|

国産ゲームエンジンとして知られるOROCHIは,シリコンスタジオからAHIRUに移管して開発が続けられている。新たなOROCHI5では,主にUIの使い勝手を上げる改善と全体的なコードの見直しによる改良が行われているという。

国内での開発運営が行われているので,国内メーカーに対する手厚いサポートが特徴だ。これには,各社のニーズに合わせた専用のブランチによるエンジン提供をはじめ,技術者の派遣なども含まれる。多くのミドルウェアメーカーと提携しており,それらの組み込み費用がかからないなどといった特徴も備えている。